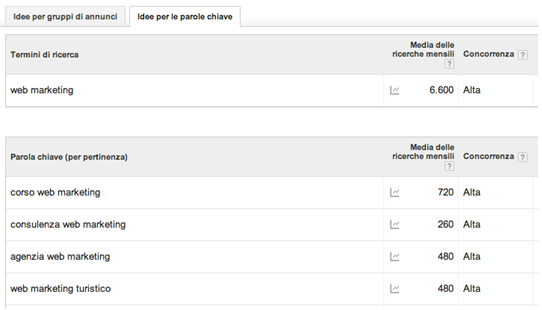

Ogni volta che decido di migliorare il posizionamento di una pagina del mio sito, seguo sempre la stessa procedura. Prima di tutto cerco di capire se c’è interesse intorno all’argomento trattato nella pagina e poi verifico il livello di competizione online. Questo mi permette di capire se il tempo che dovrò impiegare per ottenere le prime posizioni su Google valga lo sforzo che dovrà essere fatto. Infatti, sarebbe inutile posizionare una pagina in cima a Google se nessuno è interessato, oppure sarebbe troppo lungo raggiungere dei risultati nel caso in cui la competitività del tema scelto fosse molto alta. Per chiarirmi le idee molto velocemente, utilizzo due strumenti gratuiti: Google Keyword Planner e SEOquake. Il primo mi permette di capire quante ricerche generano le keyword direttamente legate alla pagina che desidero spingere e il secondo mi da le informazioni che cerco a proposito della forza dei siti e delle pagine con cui mi dovrò confrontare. Fatta questa premessa, passo all’azione sapendo che, questa volta, ho preso di mira un argomento altamente competitivo, quello del web marketing. Per prima cosa mi collego con il tool Google Keyword Planner (meglio conosciuto con il nome italiano Strumento di pianificazione delle parole chiave) e inserisco il termine web marketing. Siccome non voglio risposte generiche, seppur correlate al termine da me indicato, oltre che ad aver selezionato le opzioni lingua/italiano e paese/italia, inserisco il termine web marketing anche nel campo Inclusione/Esclusione termini. Il risultato che ottengo è che, come era facile intuire, l’argomento è molto ricercato su internet in tante differenti declinazioni.

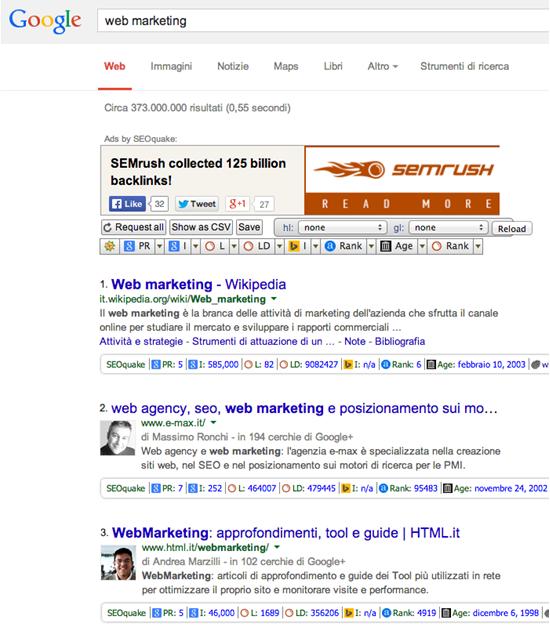

E in particolare, scopro che il termine web marketing genera all’incirca 6.600 ricerche in Italia. La prima verifica mi spinge ad proseguire la mia ricerca, sapendo però che troverò una competitività per questo termine molto alta, ed infatti questo è proprio quello che accade. In questo caso, come accennato prima, per valutare questo aspetto mi avvalgo della fantastica estensione per Chrome, che prende il nome di SEOquake (ci sono versioni gratuite anche per browser differenti). Con questa estensione attiva, faccio la mia verifica, inserendo sul campo di ricerca di Google.it il termine web marketing.

La figura sopra, fa capire come viene modificata la pagina di Google quando SEOquake è attivo. In particolare otteniamo tutta una serie di informazioni (modificabili dalle preferenze dell’estensione) che mi permettono di fare una valutazione generica sulla forza dei siti suggeriti da Google. In particolare, quello che mi interessa sapere è il PageRank e i link diretti alle pagine che appaiono come risultati. Su 373 milioni di pagine recensite riconducibili al termine da me inserito, vedo che i primi tre posti sono occupati da siti che ovviamente Google ritiene molto autorevoli in materia. Il primo posto è occupato da una pagina di Wikipedia, il secondo dal sito e-max.it e il terzo dal sito html.it con la sua sezione dedicata al tema di mio interesse. Su Wikipedia c’è poco da dire, l’autorevolezza del sito è indiscutibile, e c’è poco da dire anche su gli altri due. E-max ha un PageRank addirittura pari a 7 (lo stesso di google.it, tanto per fare un paragone) e 464.067 link (fonte semrush.com), mentre per html.it il PageRank è pari a 5 e 1.689 link. Nota bene, il PageRank e i link in entrata non sono gli unici elementi che valuto per capire se un sito è autorevole, ma come prima analisi utilizzo questi valori per farmi un’idea indicativa sulla competitività della keyword. E proprio quando sto per abbandonare l’idea di promuovere il termine web marketing per il mio sito, decido di continuare con le mie valutazioni scoprendo qualcosa che da una parte mi ha lasciato a bocca aperta, dall’altra conferma l’idea che mi frullava in testa da molto tempo, che vi farò capire alla fine di questo articolo. Per approfondire il tipo di valutazione che sto facendo, utilizzo altri strumenti gratuiti che Internet mette a disposizione come Majestic SEO. Questo sito, dietro una registrazione gratuita, fornisce interessantissimi parametri, come la quantità e la qualità dei link diretti verso una pagina di nostro interesse, per capire in modo più dettagliato la forza che ha un determinato dominio. Mi collego con la loro home page, accedo al mio account e inserisco il primo dominio che voglio analizzare e con il quale, almeno in teoria, dovrei entrare in competizione. Il risultato che ottengo mi spalanca le porte verso un viaggio la cui destinazione era ignota solo pochi minuti prima.

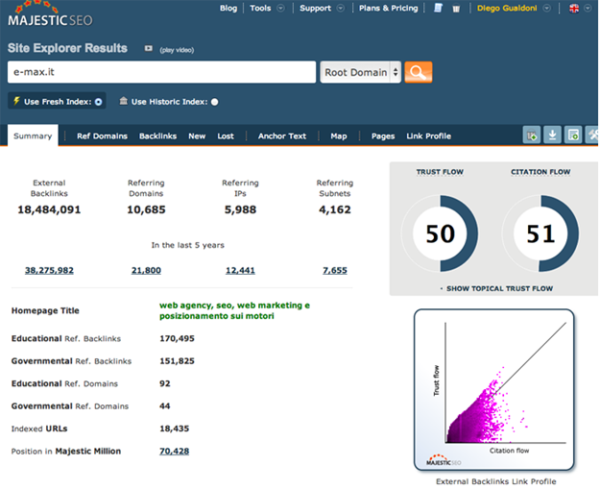

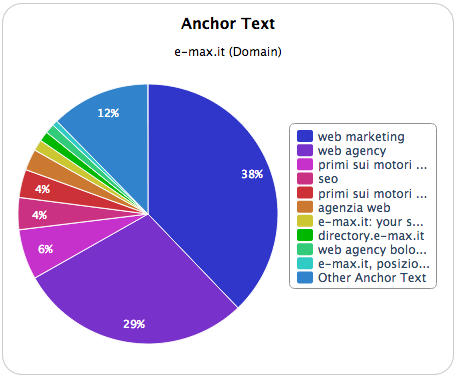

I valori che mi fanno sobbalzare sulla sedia sono il numero di link diretti al sito e-max.it. Come potete vedere sono oltre 18 milioni (esatto, proprio così). Di primo acchito ho pensato: wow, chi ha realizzato e promosso questo sito ha fatto un capolavoro, tanto di cappello. Quando mai sarò in grado di ottenere risultati anche solo lontanamente paragonabili a questi? Dopo un primo momento di ammirazione, sono andato a vedere un altro parametro, e cioè la distribuzione di anchor text e l’immagine che segue è il risultato ottenuto.

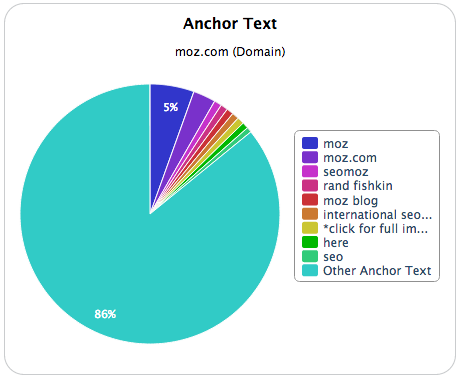

Come potete vedere, il termine web marketing ha la percentuale maggiore. Questo significa, che dei 18.000.000 di link individuati da Majestic SEO, oltre 7 milioni sono composti da un anchor text fatti con la sola keyword web marketing (termine per il quale è-max è terzo su google). Mentre per il termine web agency (termine per il quale è-max è sesto su google), i link individuati sono oltre 5 milioni. A questo punto ho cominciato a pensare che qualcosa non tornava… Allora, per fare un confronto molto generico, ho preso un sito che per chi si occupa di SEO e di web marketing è punto di riferimento, a livello mondiale, e cioè Moz. Bene, secondo Majestic SEO, il sito moz.com ha in totale meno di 2 milioni di link (ben nove volte in meno di e-max) e un profilo backlink decisamente molto più naturale.

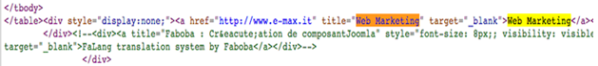

Come potete vedere, la prima keyword strategica (escluso il brand moz.com) è seo ed ha una percentuale inferiore al 5%. Quindi ero in presenza di due profili molto diversi. Mi rendo conto che confrontare i due siti in questo modo lascia il tempo che trova ma l’effetto è quello di avermi reso ancora più curioso e spinto a saperne di più. E vi assicuro che la mia curiosità è stata ripagata. Alla grande. Quello che ora dovevo fare, era capire come il sito e-max era riuscito ad ottenere 7 milioni di link con il termine web marketing e 5 con il termine web agency. Se loro ce l’hanno fatta, allora ce la devo fare anche io. Se andate a vedere la sezione Backlinks di Majestic SEO, potete osservare 5 pagine esterne dove sono presenti i link diretti a e-max e l’anchor text utilizzato (oltre ad altri valori). Disponendo di un account a pagamento, le informazioni che si possono ottenere sono certamente più approfondite, ma per il momento è più che sufficiente. Il primo link che vado a controllare è il seguente: http://www.iti.gov.br/index.php/icp-brasil Si tratta addirittura del sito dell’Istituto Nazionale di Tecnologia dell’Informazione brasiliano. Con il comando Trova cerco di individuare sulla pagina in questione l’anchor text web marketing, ma niente da fare, non si trova. Allora controllo il sorgente della pagina ed effettuo una nuova ricerca e quello che segue è il risultato che ottengo:

Come vedete il link c’è ma non si vede con il browser. Boh, non capisco… Allora controllo il secondo link: http://www.venicemarathon.it/index.php/it/ Anche qui ottengo lo stesso risultato, dal browser niente, ma visualizzando il sorgente ottengo quello che mostro nella figura che segue:

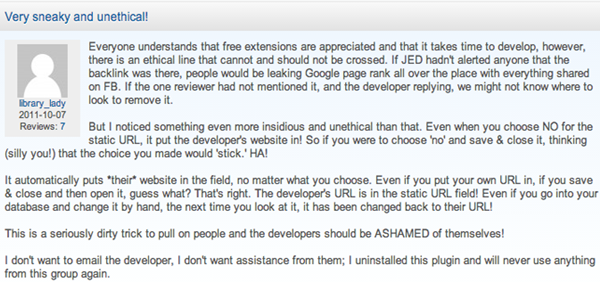

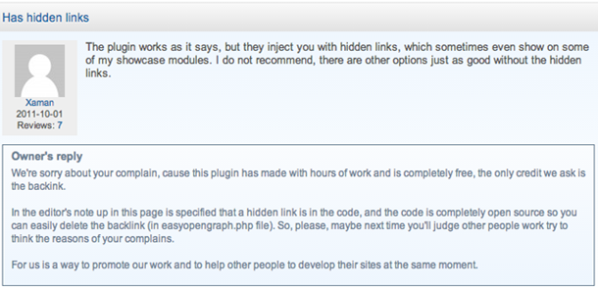

I due link hanno il tag display:none. Ma mentre il primo non so come possano averlo inserito, il secondo è associato ad un plugin per Joomla. Per capire da quanto tempo questi link sono presenti sui rispettivi siti, faccio riferimento a Archive.org e scopro che il primo è attivo almeno da Giugno 2013, mentre il secondo da Aprile 2013. Questo significa che non sono link recenti, anzi. Per farla breve, senza entrare nel dettagli delle ulteriori indagini che ho fatto, ho scoperto che e-max ha pubblicato diversi plugin che una volta installati su un sito che gira sotto Joomla, pubblicano, in modo nascosto (display:none), un link strategico collegato a e-max. Questo ha fatto infuriare diversi utenti che hanno pubblicato le loro veementi proteste attraverso questa pagina. Ecco, in particolare una di loro:

Questa è la risposta dell’autore del plugin:

A questo punto, dopo aver fatto altri controlli appare chiaro che:

- Tutti i siti che ho avuto modo di controllare, in cui è posizionato il loro link, girano sotto Joomla

- Tutti i link che ho avuto modo di controllare, sono nascosti (display:none)

- Quasi tutti i link che ho avuto modo di controllare, sono associati ai plugin rilasciati gratuitamente

- Tutti i link che ho avuto modo di controllare, sono attivi da molto tempo, alcuni da più di un anno

Questo significa due cose; la prima (non trascurabile) è che ovviamente non posso e non ho potuto controllare 18 milioni di link, la seconda cosa è che non si capisce perché i link rilevati siano tutti nascosti. A tal proposito, riporto due link, fondamentali per inquadrare la situazione, che indicano chiaramente quale deve essere il comportamento del webmaster in funzione della promozione del proprio sito. La prima pagina è raggiungibile attraverso questo indirizzo: https://support.google.com/webmasters/answer/66353?hl=it, mentre la seconda pagina è raggiungibile attraverso questo indirizzo: http://blog.e-max.it/web-marketing-bologna/white-hat-seo.html Entrambe le pagine dicono come sia vietato utilizzare la tecnica del testo e dei link nascosti. Notare come, paradosso dei paradossi, il secondo link è un articolo pubblicato proprio tramite il blog ufficiale di e-max. Ecco cosa c’è scritto sulla pagina di Google: “La presenza di testo o link nascosti nei tuoi contenuti per manipolare il tuo ranking nei risultati di ricerca di Google può essere considerato ingannevole e costituisce una violazione delle Istruzioni per i webmaster di Google.” Conclusioni Dopo una lunga premessa, giunge il momento di trarre le conclusioni. Tuttavia, decido di non farlo. Infatti, non voglio esprimere giudizi sulla strategia adottata da e-max, non è questo il punto. Preferisco che lo facciate voi. Anzi, vorrei che tutti facessero le proprie verifiche e approfondimenti al fine di confermare o ribaltare completamente i dati riportatati in questo articolo. Quello che invece voglio fare, è aprire una discussione su Google e su il suo ruolo sul web. Per questo motivo riprendo il titolo dell’articolo e riscrivo: “Google, paladino del web o arbitro incapace?” Nel primo caso dovremmo pensare a Google come un paladino del web, alla costante ricerca di siti e contenuti di qualità, per il solo ed esclusivo bene degli utenti. E se questo è vero dovremmo ritenere Google alla stregua di un’autorità morale e assecondarlo in religioso silenzio applicando alla lettera le linee guida per webmaster. Nel secondo caso invece, dovremmo ritenere che Google non sia così autorevole come la quasi totalità di chi lavora online crede, in quanto, un motore di ricerca che non è in grado di individuare strategie (perpetrate per diversi mesi) apparentemente fuori dalle linee guida, che lui stesso ha stabilito, è un motore inefficace ed incapace. Io, la mia opinione, me la sono fatta. Quale è la vostra? Non vedo l’ora di leggere le vostre considerazioni attraverso la sezione commenti. Autore: Diego Gualdoni di SeoLogico.it, per il TagliaBlog. UPDATE: il 12 Maggio 2014, Matteo Landi ha pubblicato sul blog di e-max una articolata risposta all’analisi pubblicata qui sopra. Invito tutti a leggere la replica per comprendere anche il punto di vista dell’interessato, come è giusto e sacrosanto che sia.